L’Intelligence Artificielle (IA) est partout, de plus en plus utilisée, transformant la manière dont nous abordons nos tâches. Elle se révèle comme un assistant précieux, permettant d’aider les personnes à accomplir plus rapidement leurs activités du quotidien.

Dans le domaine de la manipulation de son en texte, elle nous offre des retranscriptions rapides, mais une intervention humaine reste indispensable pour garantir la justesse et la pertinence du contenu généré.

Dans cet article, nous allons vous parler de notre expérience avec l’IA dans la production de notre podcast Zenikast et plus particulièrement celle de Google : Gemini

🎙️ Zenikast, une nouvelle aventure

Quand nous avons lancé Zenikast, le nouveau podcast de Zenika, nous nous sommes interrogés sur la manière de rendre accessible nos futurs épisodes.

L’accessibilité , et surtout quand il s’agit de podcast, n’est malheureusement pas souvent une priorité. A Zenika, c’est un sujet qui nous tient à cœur. Nous avons la volonté d’amener l’accessibilité au sein de nos prestations, nos audits, nos formations et aussi lors de nos activités annexes comme le podcast !

Sur les plateformes de podcast comme Apple podcast ou bien Youtube, des transcriptions automatiques sont générées, laissant parfois, voire souvent, des erreurs et diverses hallucinations. Nous le savons, les outils basés sur l’IA s’améliorent jour après jour mais nous avions l’envie et la volonté de mettre à disposition une transcription quasi parfaite. Pour mettre à disposition cette transcription, nous avons opté pour une solution simple et efficace : un Google Doc. Nous avons un outil interne qui permet de créer des liens vers des pages web ou documents et éviter de mentionner le lien du document tel quel. Nous pouvons donc avoir rapidement et simplement un lien de type https://links.zenika.com/link/zenikast/episode-1.

Merci à Emmanuelle Aboaf pour avoir pris le temps de répondre à nos questions et pour tes conseils 🙏.

🧪 Nos premiers essais: Whisper Transcribe

Pour la saison 1, nous étions plusieurs personnes au profil technique à s’occuper du podcast. Nous avons donc testé différents outils, basés sur des projets Node.js, Java, ou bien sur des outils directement à installer. Mais Zenikast a pour vocation d’être à la disposition de toutes les personnes de Zenika, qu’elles soient tech ou non. L’outil et la manière de créer nos transcriptions doivent donc être accessibles à tous les profils des collaborateurs et collaboratrices de Zenika.

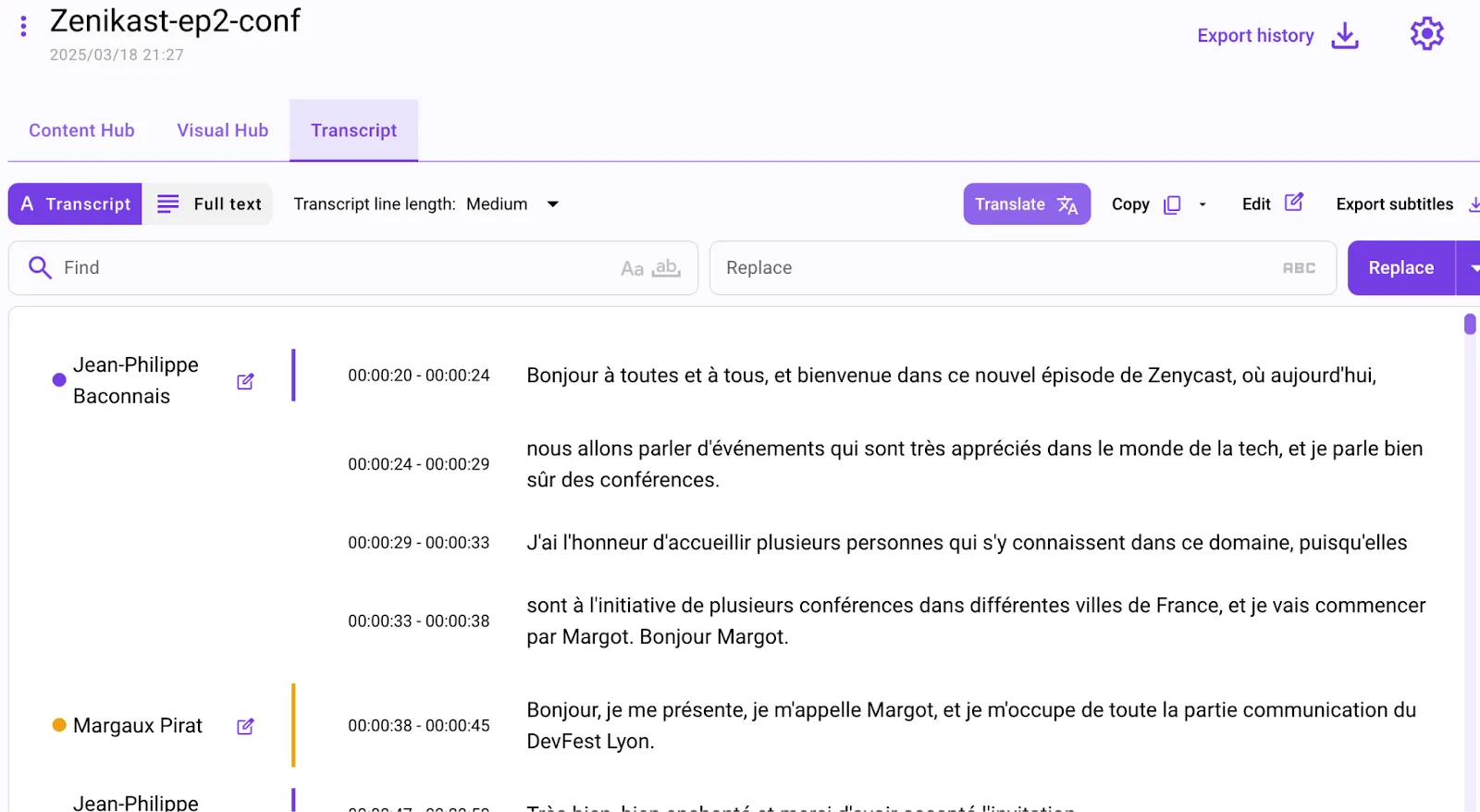

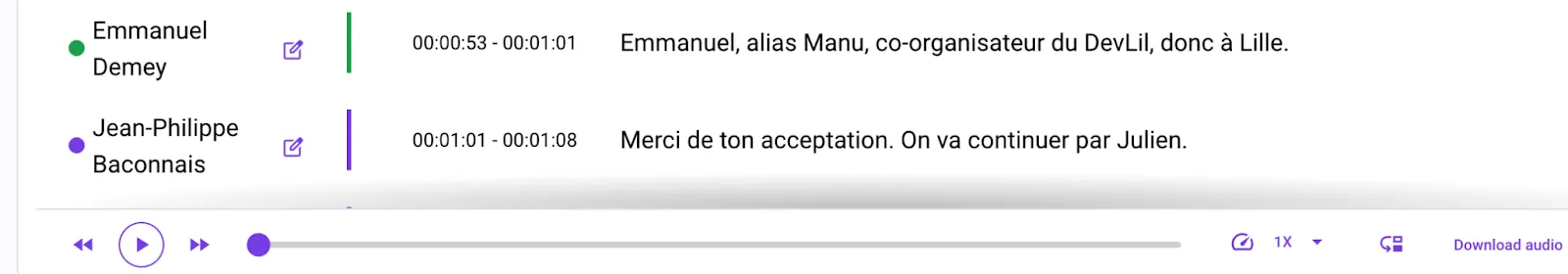

Nous avons sélectionné Whisper Transcribe, et avons pu tester nos premières transcriptions avec la version gratuite . Merci aux personnes qui ont travaillé sur ce magnifique projet 💪.

Petit plus de Whisper : la diarisation, ou détection automatique des différents intervenants·es dans le podcast, une fonctionnalité très utile pour nos épisodes pouvant avoir jusqu’à 6 voix.

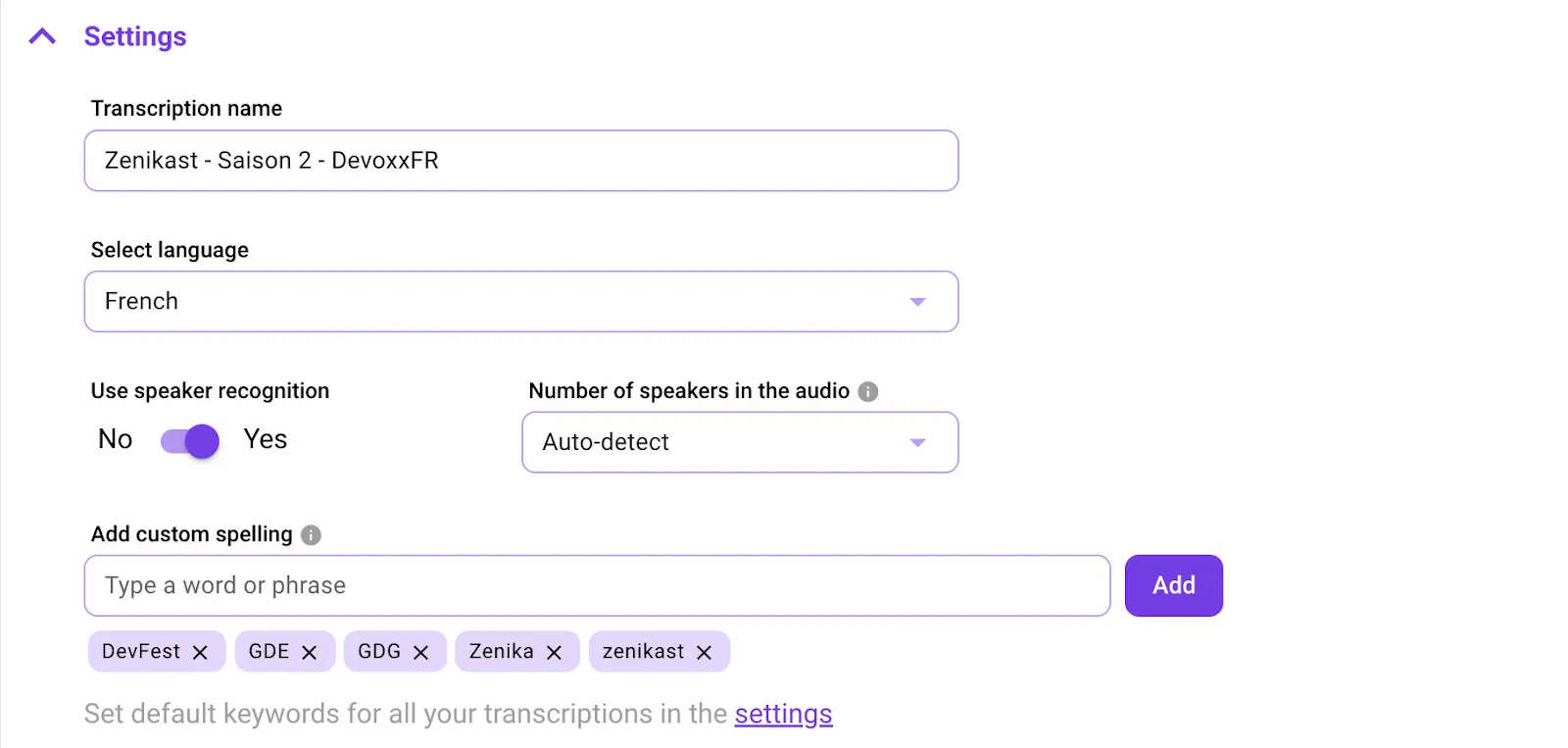

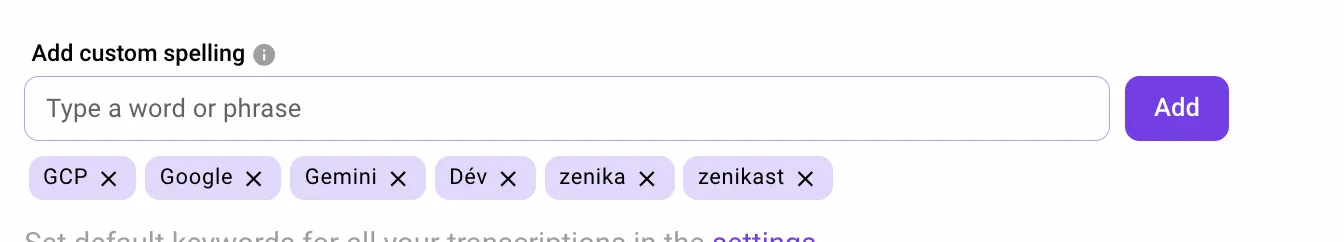

Des mots spécifiques, abréviations ou termes techniques peuvent être ajoutés à la liste des mots “connus” de Whisper.

Malgré sa qualité, chaque transcription demandait tout de même plusieurs heures de relecture pour arriver à un texte sans erreur et structuré de façon à être agréable à lire. De plus, Whisper Transcribe est payant pour une utilisation plus intense.

💡 Vers l’IA générative avec Vertex AI

Lors du Devoxx France mi-Avril, une discussion avec Valentin Deleplace nous a orienté et surtout convaincu de pousser nos expérimentations avec Gemini et Vertex AI Studio de Google Cloud. Il est possible d’y importer un fichier audio (.mp3 ou .wav) et de demander à Gemini de nous donner la transcription de l’épisode, sans écrire une seule ligne de code.

Le rendu est largement satisfaisant et a poussé notre curiosité à tester d’avantage la transcription de notre épisode de podcast que nous tournions d’ailleurs pendant le Devoxx (cf la vidéo de l’épisode) avec les solutions Google.

🧪 Retour d’expérience : Gemini 2.5 Pro à l’épreuve

Nous sommes donc allés tester directement avec le dernier modèle : Gemini 2.5 Pro.

Disponible en preview via Vertex AI, Gemini 2.5 Pro a la capacité de traiter des prompts multimodaux : texte, image, audio, voire même vidéo. Contrairement aux générations précédentes, il intègre des capacités de raisonnement bien plus poussées.

La prise en main est rapide : en important un fichier .mp3 ou .wav, nous avons interagi avec le modèle directement dans l’interface de Vertex AI Studio et en quelques secondes Gemini génère un texte très fluide et assez fidèle à l’audio. Là où Whisper Transcribe nous demandait une bonne relecture, Gemini a nettement réduit ce temps. Mais surtout, il est aussi capable de faire de la diarisation, c’est-à-dire de détecter et séparer les différentes voix intervenant dans le podcast.

🪜 Étape 1 : Transcription avec détection des voix

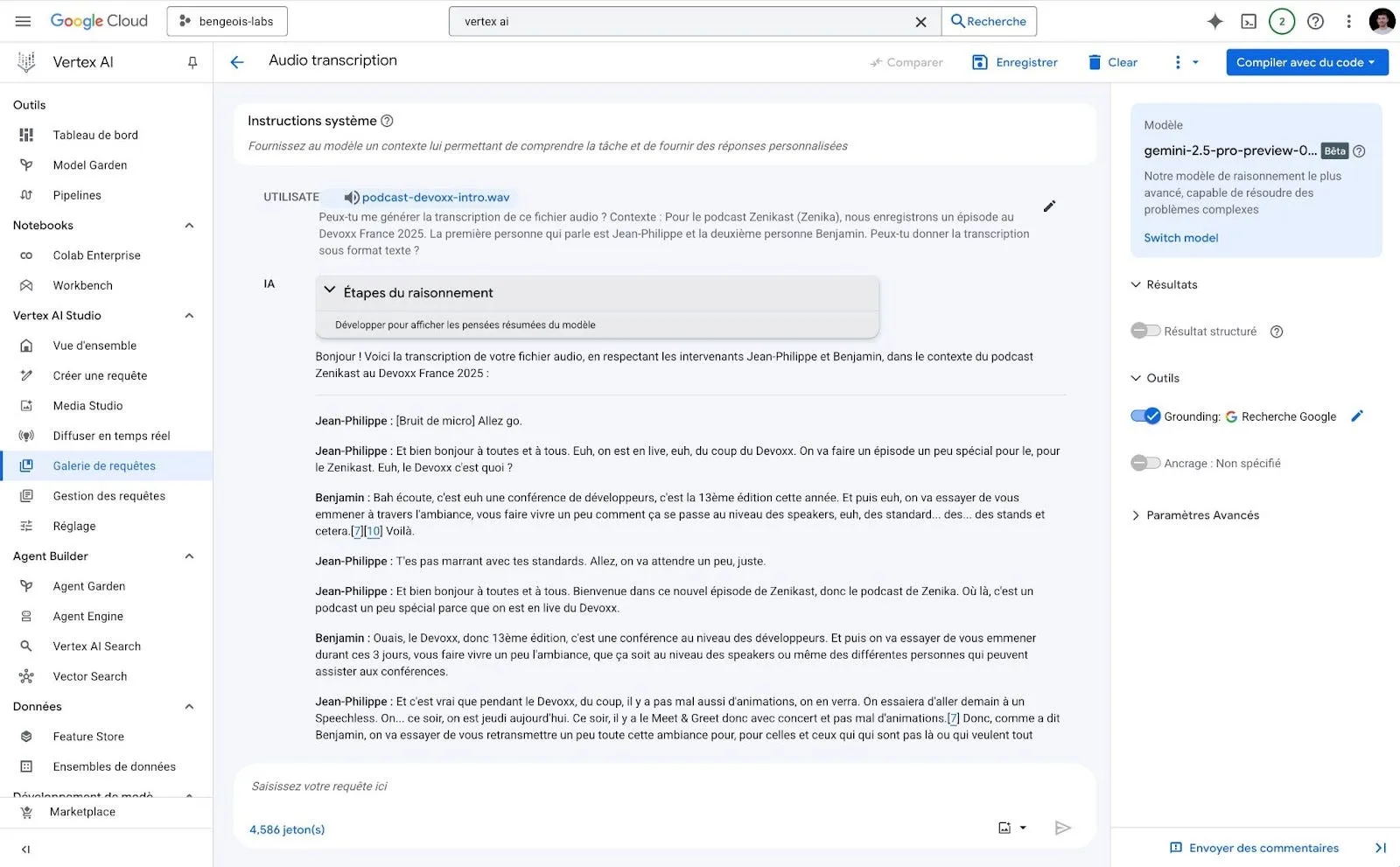

Nous avons importé un fichier .wav dans Vertex AI Studio et formulé une simple instruction.

Peux-tu me générer la transcription de ce fichier audio ?

Contexte : pour le podcast Zenika (Zenikast), nous enregistrons un épisode au Devoxx France 2025. La première personne qui parle est Jean-Philippe et la deuxième personne Benjamin.

Peux-tu donner la transcription sous format texte ?

En quelques secondes, Gemini a produit une transcription structurée, segmentée par “Intervenant 1”, “Intervenant 2”, etc.

Le résultat brut est vraiment satisfaisant. Pas d’hallucinations, très peu d’erreurs de transcription, et surtout une bonne compréhension des enchaînements entre les intervenant·es. Cette étape nous a convaincus du potentiel. Mais on voulait aller plus loin : améliorer la lisibilité du texte pour en faire un support plus agréable à lire, voire publiable tel quel.

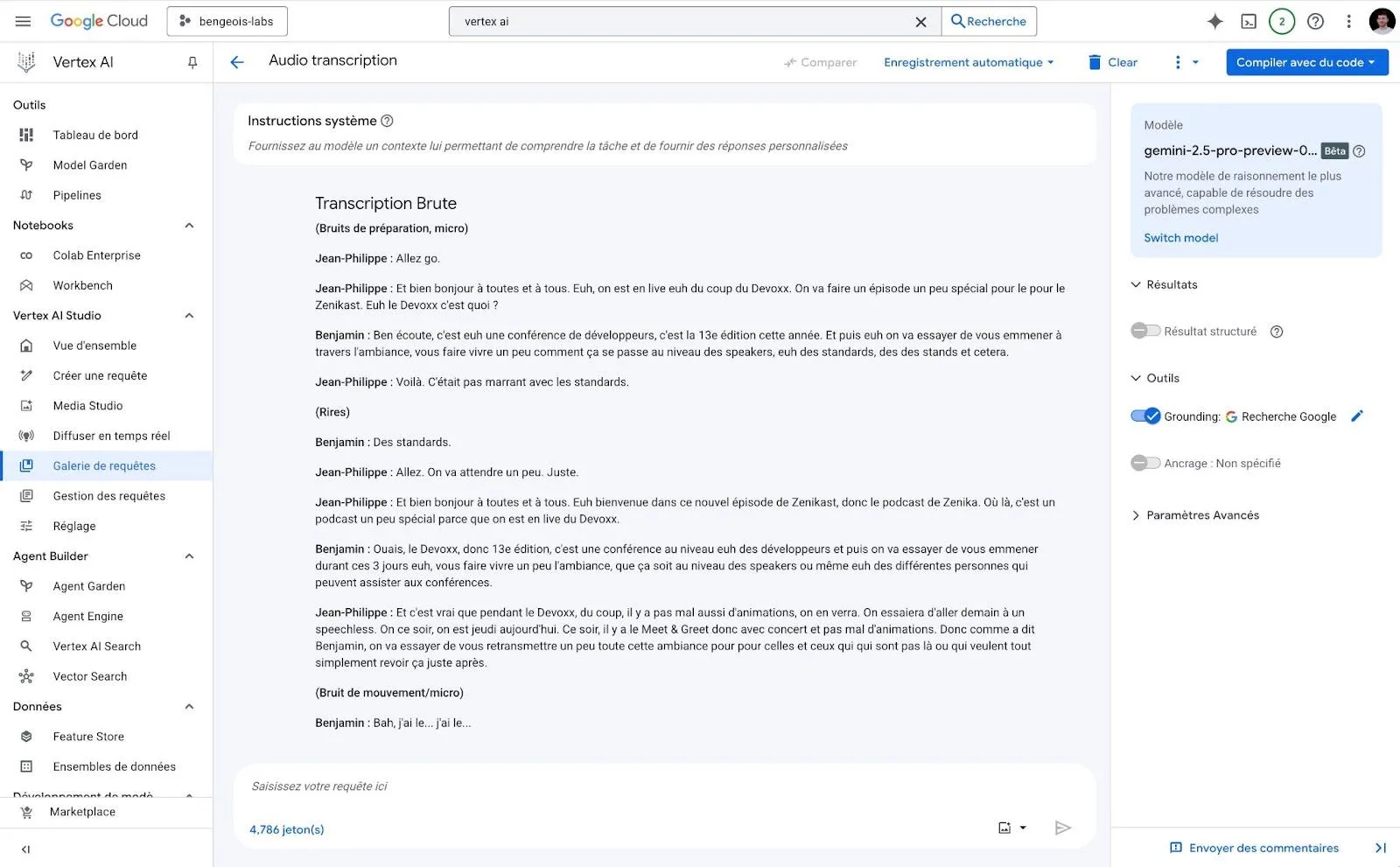

🪜 Étape 2 : Nettoyage automatique des tics de langage

Lors d’un second prompt, nous avons demandé exactement la même transcription mais en enlevant les tics de langage : les “du coup”, “euh”, “voilà”, “en fait” et autres. Gemini a gardé l’esprit de l’échange, sans trahir le propos, mais en le rendant bien plus fluide à la lecture.

Un vrai gain pour les personnes qui liront la transcription sur le lien partagé.

Voici le prompt :

Peux-tu me générer la transcription de ce fichier audio ?

Contexte : pour le podcast Zenika (Zenikast), nous enregistrons un épisode au Devoxx France 2025. La première personne qui parle est Jean-Philippe et la deuxième personne Benjamin.

Peux-tu donner la transcription sous format texte ? Peux-tu également nettoyer le texte de façon à supprimer les tics de langage comme les “euh”, les répétitions de mot, etc afin de le rendre lisible tout en restant fidèle au texte au maximum.

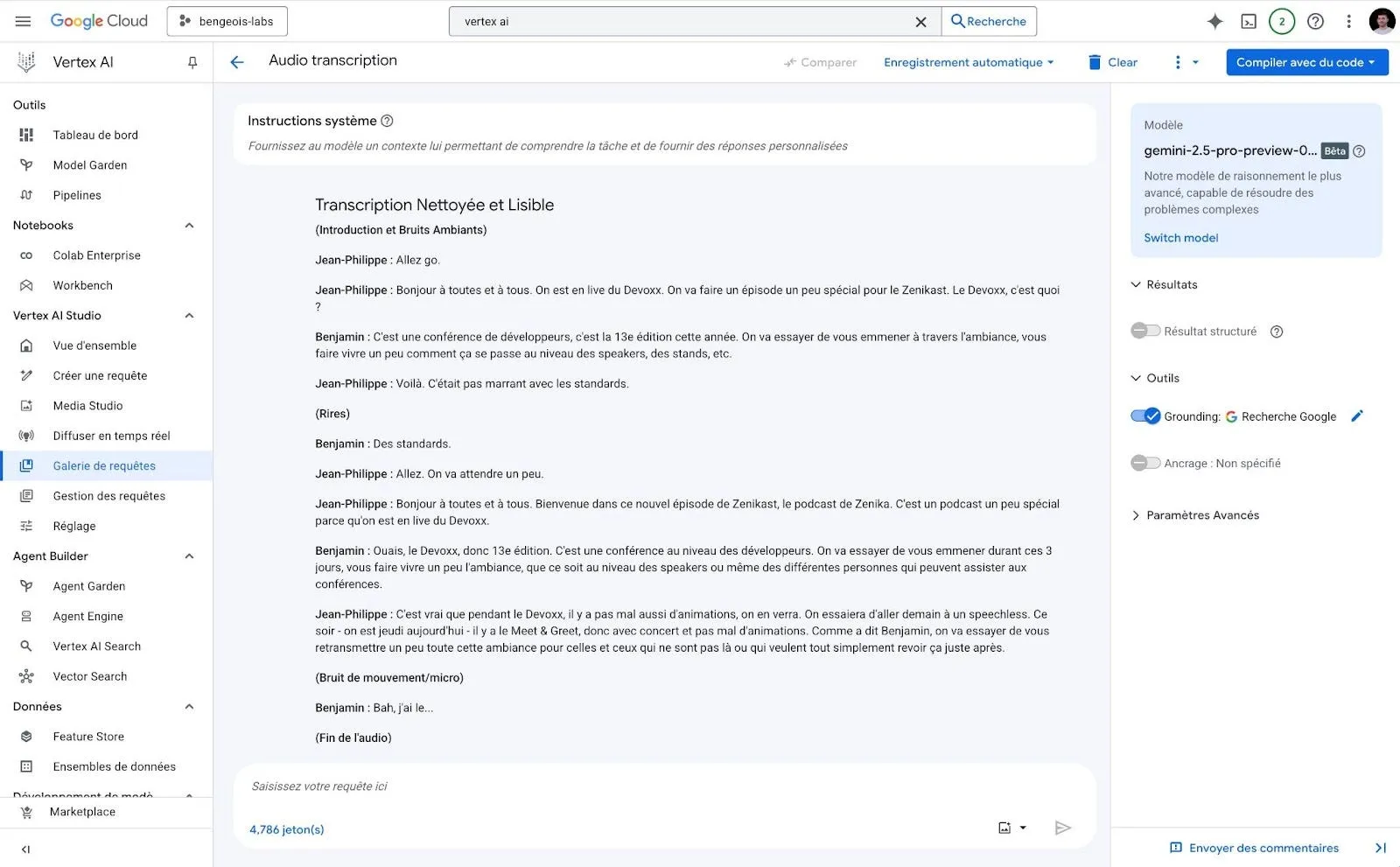

🪜 Étape 3 : Deux versions complémentaires

Ce double rendu nous permet maintenant d’avoir à la fois une version fidèle à l’original et une version plus lisible.

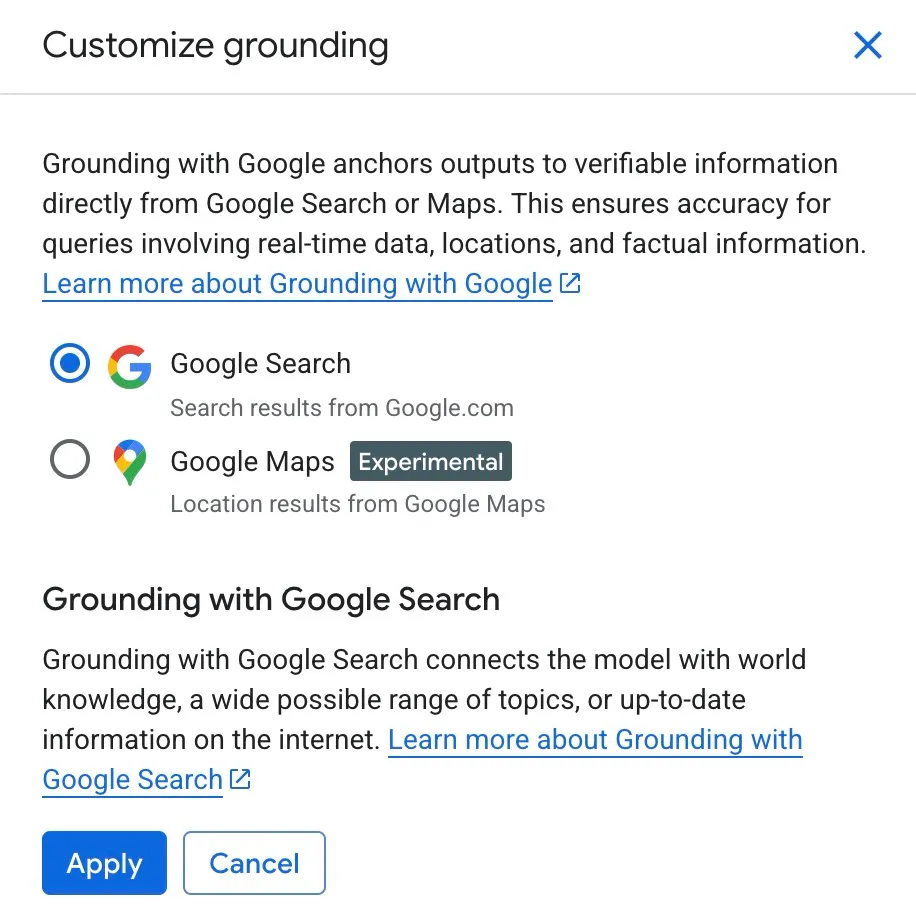

🧭 Grounding : des réponses vérifiées via des sources fiables

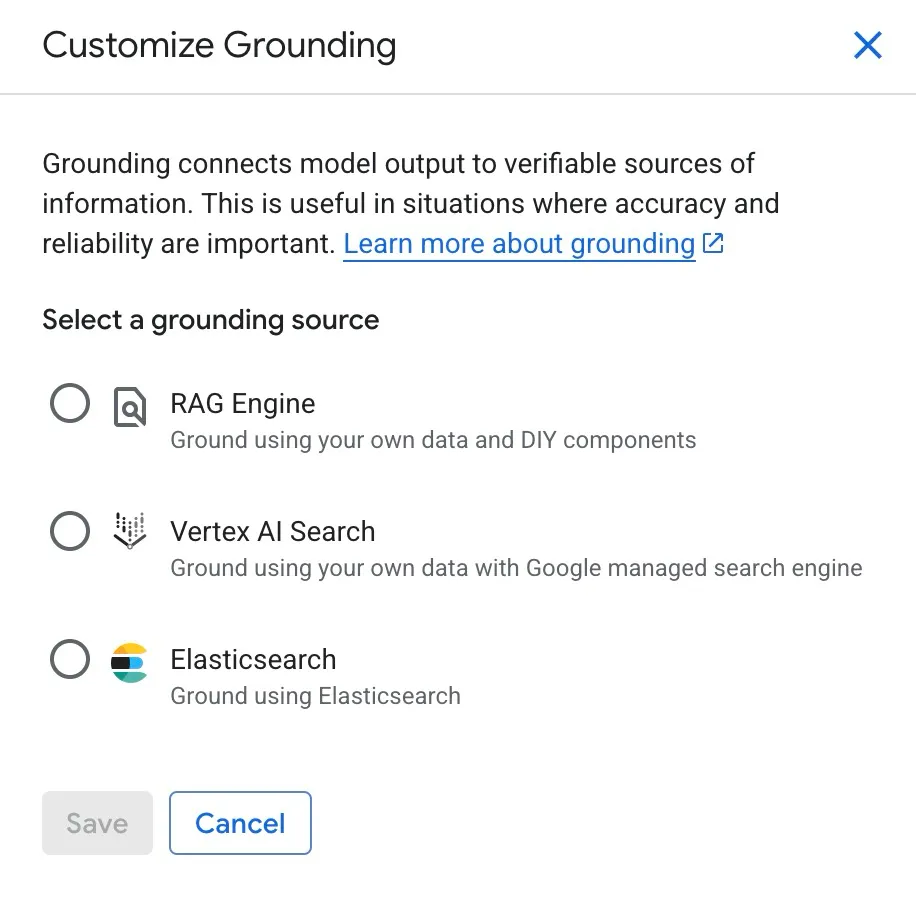

Sur les captures d’écran précédentes, vous remarquerez l’activation d’une option nommée “Grounding” sur le panneau de droite.

L’idée est de connecter Gemini à des sources de données vérifiables, comme la Recherche Google, Google Maps ou même vos propres données. Cela permet de réduire drastiquement les risques d’hallucinations.

Par exemple, si on demande à Gemini de résumer un article de presse récent, de générer un contenu à jour, ou même de répondre à une question pointue sur un sujet en constante évolution, le grounding avec la Recherche Google permet d’adosser sa réponse à des contenus web récents et pertinents. Mieux encore : les réponses peuvent être accompagnées de citations et de scores de confiance, ce qui renforce l’auditabilité et la transparence.

Du côté de vos données, il est possible de connecter Gemini à du RAG Engine, du Vertex AI Search ou de l’Elasticsearch.

🚀 La suite, basée sur des agents IA?

L’utilisation de l’Intelligence Artificielle, que ce soit Whisper Transcribe ou dernièrement Gemini, nous a permis de gagner plusieurs heures sur la transcription de nos épisodes. Lors des premiers tests, nous passions 3 à 4h pour relire et corriger un épisode. Pour le moment, même si cette cinématique est très archaïque et perfectible, nous n’y passons plus que 30 minutes.

Avec les annonces faites par Google courant Avril et Mai 2025, des améliorations vont rapidement pouvoir être testées et mises en place pour accélérer ce processus et permettre à tous les collaborateurs et collaboratrices de Zenika de réaliser des transcriptions en quelques clics via la plateforme AgentSpace, le protocole Agent2Agent (A2A) et le framework Agent Development Kit, ADK. Nous vous raconterons sûrement cela dans un nouvel article de blog.

👉 Article rédigé avec Jean-Philippe Baconnais